Entenda o que está em jogo com julgamento no STF do artigo 19 do Marco Civil da Internet

Corte quer definir sobre a constitucionalidade do ponto que trata da liberdade de expressão nas redes

Bastante debatido nos últimos anos no mundo todo, o papel das big techs na moderação dos conteúdos é alvo de julgamento no Supremo Tribunal Federal, que começou na última quarta-feira (27) e terá sua terceira sessão nesta quarta-feira (4).

Durante as audiências, os ministros vão decidir se as plataformas podem ser diretamente responsabilizadas por postagens ilegais e se os conteúdos devem ser removidos pelas próprias empresas que operam as redes sociais, sem que haja decisão judicial prévia.

Tudo isso afeta diretamente a constitucionalidade do artigo 19 do Marco Civil da Internet, um dispositivo amplamente debatido com a sociedade civil em 2014 a partir de princípios como a neutralidade da rede e a liberdade de expressão no contexto de avanço das plataformas. A Lei 12.965/14 foi considerada um avanço ao ser aprovada e um exemplo para o debate em outros países.

O artigo que está em questão no julgamento aponta que a palavra final sobre a retirada de conteúdos ofensivos é do Judiciário, em um modelo chamado “judicial notice and takedown”. Dessa forma, em caso de conteúdos ofensivos, a responsabilidade de retirada passa a ser da plataforma somente após um pedido judicial; no caso de não haver a retirada no tempo determinado, aí sim a empresa fica implicada na Justiça.

Para as organizações que participam do debate formulador do Marco Civil, o artigo 19 é positivo. “O artigo se alinha com o fundamento da lei, que é a promoção da liberdade de expressão e a prevenção à censura.”, afirma o Idec, que é o Instituto de Defesa do Consumidor.

A prevenção à censura destacada no posicionamento do Idec é um dos principais pontos de discussão, pois, para um conjunto de ativistas digitais, não é sadio e democrático que as plataformas possam ser as principais responsáveis pela retirada dos conteúdos, já que a prática pode se tornar bastante arbitrária com o poder decisório exclusivamente nas mãos das big techs.

Constitucionalidade do artigo 19

“Entendemos que o artigo 19 é constitucional sim. Ele deixa claro que o papel de julgar o que é para ser retirado do ar não compete às plataformas, mas ao judiciário brasileiro, que é quem rege as normas no país”, afirma Admirson Ferro Jr., conhecido como Greg, coordenador-geral do Fórum Nacional Pela Democratização da Comunicação, o FNDC.

O coordenador do FNDC lembra que a cláusula referente à retirada de conteúdos também está presente em outros projetos de regulamentação que estão em discussão no Congresso. “Isso acontece no PL 2630 [das Fake News] e no PL 2338 [sobre Inteligência Artificial], então seguimos na mesma lógica, em defesa do Marco Civil, no sentido de aprimorá-lo.”, comenta Greg.

O CGI, Comitê Gestor da Internet, uma estrutura multissetorial com a responsabilidade de coordenar e integrar as ações sobre o assunto, se pronunciou em nota pública apontando que reitera a defesa da constitucionalidade do artigo 19 e sublinha “a necessidade de se modular a responsabilização dos agentes de acordo com os limites de suas atividades ou condutas”.

Além das organizações da sociedade civil, as próprias empresas, por outros motivos, também se manifestaram contrárias às alterações em questão. “É incompatível com a Constituição Federal impor aos provedores o dever de fiscalização prévia de conteúdos de terceiros”, disse a advogada do Facebook durante a sessão, segundo noticiou o portal Jota.

O ambiente geral entre as plataformas e o STF não é dos melhores, em especial após os ataques do 8 de janeiro e a resistência de cumprimento de ordens da rede X, cujo proprietário é Elon Musk. Uma reportagem do site Aos Fatos trouxe o papel importante da disseminação de uma fake news que falava sobre o papel moderador do Exército no caso de golpe de Estado, revelado no recente relatório da Polícia Federal sobre o assunto.

Nesse sentido, para o relator de uma das ações do julgamento do artigo 19, o ministro Dias Toffoli, a atual normativa é burocrática, já que prevê que redes tenham responsabilidade civil apenas depois de receberem ordem judicial, sem adotarem providências e terem prazo de remoção que respeite limites técnicos no serviço.

Quem também já se manifestou foi Alexandre de Moraes, conhecido justamente por travar grandes embates com as plataformas. Para Moraes, o episódio de 8 de janeiro demonstrou a “total falência” da regulamentação atual. O ministro do STF apontou que esse é um dos julgamentos mais importantes do ano e destacou ainda sua saga em desabilitar perfis falsos registrados em seu nome.

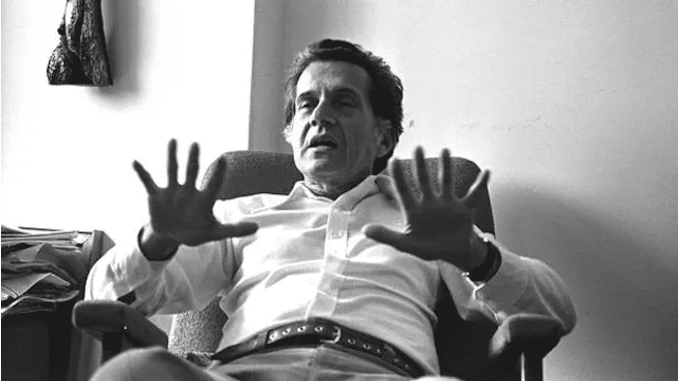

“Esse papel regulador das plataformas é inexistente do ponto de vista da sociedade. Elas até podem regular o que elas têm interesse a partir dos algoritmos, isso elas de fato fazem, privilegiando ou desprivilegiando os conteúdos de acordo com interesses empresariais e, muitas vezes, políticos”, comenta o jornalista e doutor em Ciências da Comunicação pela USP, Lalo Leal Filho.

Lalo afirmou ser praticamente inexistente a regulação no que diz respeito aos interesses gerais da sociedade, mas alerta sobre os riscos da moderação dos conteúdos ser feita de forma exclusiva pelas plataformas. “Há a necessidade delas, no mínimo, atenderem às demandas da sociedade, quando determinados setores sociais julguem que as informações são fraudulentas ou inverídicas”, pondera.

A título de exemplo, o Laboratório de Estudos de Internet e Redes Sociais, o NetLab, vinculado à Universidade Federal do Rio de Janeiro, a UFRJ, identificou e classificou 1.565 anúncios publicitários dirigidos às mulheres como problemáticos, irregulares ou ilegais/fraudulentos. O estudo mapeou 550 páginas classificadas como “tóxicas”, apenas no período de coleta entre janeiro e fevereiro deste ano.